許陳鑑 優聘教授 | 電機工程學系

1997年於School of Microelectronic Engineering, Griffith University, Australia取得博士學位。曾任IBM Corporation系統工程師,IEEE SMC Society台北分會主席,目前是IET Fellow。研究興趣在於數位控制系統、演化計算、示範學習系統、移動機器人導航。

【本篇報導由電機工程學系 許陳鑑優聘教授研究團隊提供】

AI在機器視覺領域影響深遠,促使人們想運用機器來模仿人眼,感知所看到的物體在現實空間的姿態。當機器人能有人類對物體姿態的空間認知,物件夾取或情境描述等服務人類的相應應用勢必能帶進更多AI創新技術。近年來基於機器學習之姿態估測技術,多朝著「先概略估計再迭代修正」的流程來獲得最後的判定成果,但是,這些迭代模型大多只利用到幾何空間特徵,忽視了色彩特徵的價值。故本研究設計了一套同時利用幾何和色彩特徵資訊的迭代式姿態估測系統,實驗結果證明,能夠在知名的LINEMOD和YCB-VIDEO資料集上有優異表現。

人類的視覺感知如同照相機一般,隨時間不斷地拍下現實空間觀測的影像,而大腦則負責將這些影像統整分析,造就人類的空間認知,使我們能描述對所見物體的姿態,進而能夠使用工具改善生活。近年來工業化需求大幅提升,科學界藉由不斷的研究,希望也能藉由AI模仿人類大腦來感知物體姿態,讓機器人根據這些訊息判讀環境、挪移物體和完成特定任務。因此,物件姿態估測系統一直是機器人應用的重要關鍵之一。

傳統物件姿態估測方法分成基於特徵方法和基於範本方法兩種,前者會比對物體三維模型投影到二維影像之間的關聯性,但會受制於物體紋理不夠清晰使得判斷準確率降低;後者會查詢既有物體不同姿態的範本影像來做比對,但受制於真實場景複雜度太大,範本不易把所有的光影變化和物體姿態都考量進去。這議題延續至今日,因影像繪圖卡的計算能力不斷提升,帶動了基於機器學習型的方法的大幅發展。物件姿態估測代表性的方法多以一個概略估測網路,再串接一個迭代修正網路的學習模型呈現。然而,其迭代模型都只利用到幾何特徵成分,忽略了色彩特徵的價值。本研究團隊認為除了空間特徵之外,加上色彩特徵能提升物件姿態估測的準確度。

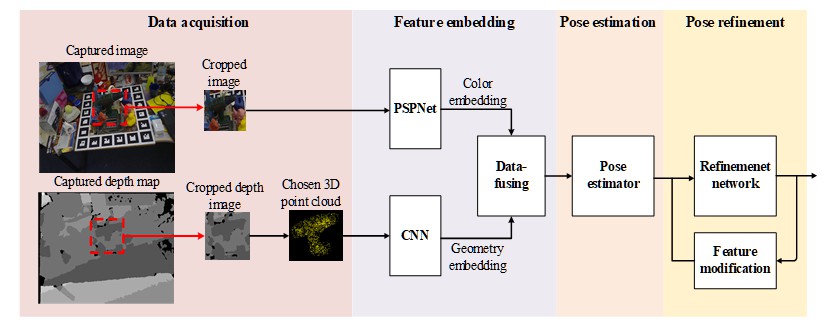

圖一:本研究團隊所提出的物件姿態估測系統模型

因此,本研究係利用影像和深度資訊,設計一套機器學習型物件姿態估測系統,其具備兩項特色:(1)過去迭代式姿態修正方法僅著重幾何成分,較少利用色彩成分,研究團隊藉由添加影像修正步驟,同時更新色彩和幾何成分以改良姿態修正網路,使準確率有所提升。(2)改良的影像修正步驟僅用OpenCV即可實現,不需要大量計算,執行時間約24ms/frame,且尚有用GPU進一步提升速度的可能性。實驗結果證明,本研究方法在LINEMOD dataset上的ADD準確率達到94.74%,勝過CVPR 2019的PVNet [R1] (86.27%)、DenseFusion [R2] (94%)、以及2020發表於ICRA的Tian [R3](92.87%);在YCB-Video dataset上的ADD準確率達到93.2%,略勝過2018著名的PoseCNN+ICP [R4] (93%)、CVPR 2019的DenseFusion [R2] (93.1%)、以及Tian [R3](91.8%)

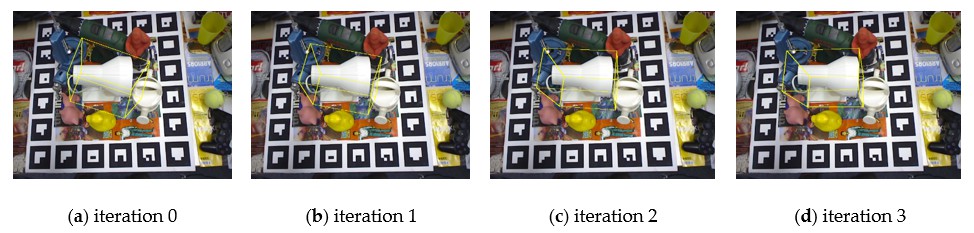

圖二:本研究團隊所提出的物件姿態估測系統迭代修正姿態估測。黃色立體線框為估測姿態成果,由(a)-(d)可看出黃色線框逐漸對準白色目標物件

綜上,本研究團隊設計了一個迭代式學習型物件姿態估測系統,利用幾何及色彩特徵資訊修正網路。實驗結果證明,其運算速度可達到24fps,在知名的LINEMOD和YCB-VIDEO資料集上有優異表現,本項技術未來可應用於機器手臂夾取物件和模擬人類空間感知進行情境判讀。

參考文獻:

[R1] S. Peng et al, “Pvnet: pixel-wise voting network for 6dof pose estimation,” in Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Long Beach, CA, USA, 15–21 June 2019.

[R2] C. Wang et al., “DenseFusion: 6D object pose estimation by iterative dense fusion,” in Proceedings of the 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Long Beach, CA, USA, 15–21 June 2019, in press.

[R3] M. Tian et al, “Robust 6D Object Pose Estimation by Learning RGB-D Features,” in Proceedings of the IEEE International Conference on Robotics and Automation (ICRA), Paris, France, 31 May–4 June 2020, to be published.

[R4] Y. Xiang et al, “Posecnn: A convolutional neural network for 6d object pose estimation in cluttered scenes,” in Proceedings of the Robotics: Science and System XIV, Pittsburgh, Pennsylvania, USA, 26–30 June 2018.

原文出處:

S.-K. Huang, C.-C. Hsu*, W.-Y. Wang, and C.-H. Lin, “Iterative Pose Refinement for Object Pose Estimation Based on RGBD Data,” Sensors, vol. 20, no. 15, July 2020. https://doi.org/10.3390/s20154114

1997年於School of Microelectronic Engineering, Griffith University, Australia取得博士學位。曾任IBM Corporation系統工程師,IEEE SMC Society台北分會主席,目前是IET Fellow。研究興趣在於數位控制系統、演化計算、示範學習系統、移動機器人導航。

目前就讀於國立臺灣師範大學電機工程研究所博士班,研究興趣在於機器學習、計算機視覺領域。